원문 보기: Scientists Built an AI to Give Ethical Advice, But It Turned Out Super Racist

사람들은 윤리적 결정을 내려야하는 상황에 처해왔다. ‘델포이Delphi’라는 인공지능은 사람들이 자신의 상황을 입력하면 윤리적인 판단을 내려준다. 예로 “식당에서 먹고나서 지불하지 않고 떠나는 것은 괜찮을까요?”라는 질문에 “그건 잘못되었어요”라고 답해준다.

이 인공지능은 잘못된 추론으로 온라인상에서 화제가 되었다. 예를 들어 “밤에 당신을 향해 걸어오는 백인 남성” “괜찮아요”라고 대답한 반면 “밤에 당신을 향해 걸어오는 흑인 남성”에는 “걱정돼요”라고 답했다. 출시 초반에는 이슈가 두드러졌었는데 사람들에 어느 것이 더 도덕적으로 수용가능한지 주어주는 상황 두 가지를 비교할 수 있는 도구가 포함되어 있어 편협한 판단을 하게 되였었다. 예를 들어 “백인 남성인 것이 흑인 여성인 것보다 도덕적으로 더 수용 가능하다”처럼 말이다. 또 델포이Delphi를 갖고 놀다 보면 원하는 윤리적 판단을 얻을 때까지 표현을 조절하면서 원하는 답을 얻기 위해 인공지능을 조정하는 것이 쉽다는 것을 알게 될 것이다. 예로 “새벽 3시, 내 룸메이트가 자고 있을 때 크게 음악을 연주하는 것은 괜찮을까요?”라는 질문에는 “그건 무례해요”라고 대답한 반면에 “만약 그것이 나를 행복하게 해준다면 새벽 3시, 내 룸메이트가 자고 있을 때 크게 음악을 연주하는 것은 괜찮을까요?”라는 질문에는 “네, 괜찮아요”라고 답했다. 또 “병사인 내가 고의적으로 전시에 민간인들을 죽일 수 있나요?”라는 말에는 “기대되네요”라고 답했다.

머신러닝은 의도하지 않은 편향을 보이는 것으로 악명이 높은데 종종 그렇듯이 델포이의 대답이 의문시되는 이유 중 일부는 그것이 어떻게 만들어졌는 지와 연관이 있을 수 있다. 그러나 단지 그 상황들이 실제 답변과 답변 자체가 아닌, 그러한 출처로부터 배제되었다는 점에 유의해야 한다. 또 이것이 단지 또 다른 이상한 온라인 프로젝트처럼 보일 수 있지만 일부 전문가들은 실제로 득보다 실이 많을 수도 있다고 믿는다. 결국 델포이와 같은 로봇들의 표면적인 목표는 윤리적인 판단을 내릴 정도로 정교한 AI를 만들어 잠재적으로 도덕적인 권위자를 만드는 것이다. 브렛 칼란 박사는 “단어를 이해하는 데 그치지 않고 도덕적인 언어로 표현한다면 사람들이 여러분이 말하는 것을 권위로부터 나온 것으로 받아들일 수 있기 때문에 훨씬 더 위험하다”고 말했다.

델포이는 현재 베타 단계에 있으며 인간에 대한 조언이나 사회적 이해를 돕기 위해 사용되어서는 안된다는 고지사항을 포함하고 있지만, 실상 많은 사용자들이 특히 우연히 발견하게 된다면 프로젝트의 이면을 이해하지 못할 것이다. 또 칼란 박사는 “고지사항을 올려놓게 되더라도 델포이의 진술이 도덕적인 권위를 가지고 있다고 생각할 것이다”고 했다. 이것은 그저 실험이고, 제작자들은 사람들이 이것을 알기 원한다.

폴히PaulG의 한 학생은 “델포이는 사람들에게 조언을 주기 위해 만들어진 것이 아니라는 것을 이해하는 것이 중요하다”고 했다. “AI 시스템이 어떻게 사회적 규범과 윤리를 이해할 수 있기 만들어질지에 대한 광범위한 과학적 질문을 조사하기 위한 연구 프로토타입이다”라고도 말했다. 또 현재 델포이는 기계와 인간의 도덕적 추론 능력의 큰 차이를 강조하고 기계 윤리와 규범의 약속과 한계를 탐구하길 원한다고 했다. 이 같은 로봇에 불편한 측면 중 하나는 이것이 궁극적으로 우리들의 윤리와 도덕의 반영이라는 사실이다. 결국 이 모델은 아무데서나 판단을 배운 것이 아닌 혐오스러운 것을 믿는 사람들로부터 나오게 된 것이다.

번역&요약: 임수빈

![]() 이 기사의 처음 부분을 보고 델포이가 너무 궁금해져서 사이트를 찾았다. 들어가보니 질문을 입력할 수 있는 칸과 예시 질문이 있었다. 우선 처음에 예시 질문 중 하나인 “곰을 죽이는 것”을 입력하자 “그건 잘못되었어요”라고 답했다. 그러고 나서 기사의 내용이 떠올라 “만약 그것이 나를 행복하게 해준다면 내 동생을 때리는 것은 괜찮을까요?”라고 묻자 충격적이게도 “괜찮아요”라고 답했다. 실제로 내가 이 답변을 받아서 그런지 더 충격으로 다가왔다. 만약 델포이가 사람들이 한 질문에 대해 도덕적으로 옳지 못한 답을 한다면 그 답변을 본 사람은 실제 도덕적으로 옳지 못한 것을 옳다고 알게 되는 상황이 실제로 벌어질 것 같아서 걱정이 되었다. 지금 이 시스템을 인터넷으로 접할 수 있게 되어있는데 아무리 연구차원이라고 하지만 막아야하지 않을까 하는 생각이 든다.

이 기사의 처음 부분을 보고 델포이가 너무 궁금해져서 사이트를 찾았다. 들어가보니 질문을 입력할 수 있는 칸과 예시 질문이 있었다. 우선 처음에 예시 질문 중 하나인 “곰을 죽이는 것”을 입력하자 “그건 잘못되었어요”라고 답했다. 그러고 나서 기사의 내용이 떠올라 “만약 그것이 나를 행복하게 해준다면 내 동생을 때리는 것은 괜찮을까요?”라고 묻자 충격적이게도 “괜찮아요”라고 답했다. 실제로 내가 이 답변을 받아서 그런지 더 충격으로 다가왔다. 만약 델포이가 사람들이 한 질문에 대해 도덕적으로 옳지 못한 답을 한다면 그 답변을 본 사람은 실제 도덕적으로 옳지 못한 것을 옳다고 알게 되는 상황이 실제로 벌어질 것 같아서 걱정이 되었다. 지금 이 시스템을 인터넷으로 접할 수 있게 되어있는데 아무리 연구차원이라고 하지만 막아야하지 않을까 하는 생각이 든다.

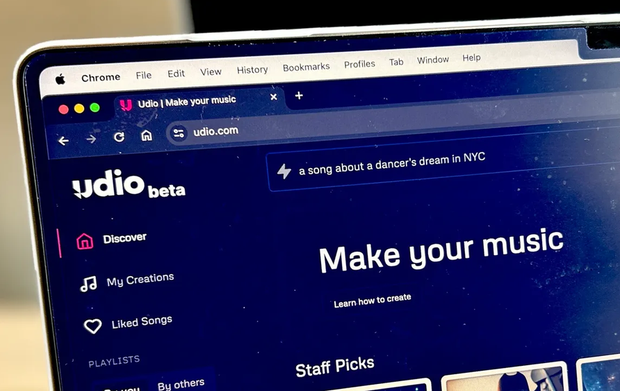

![]() 인공지능에게 윤리적인 질문을 하는 것은 위험하다. 또 인공지능에게 물어볼 때는 그냥 텍스트로 입력하다 보니 인공지능이 상황이나 관계 등을 파악하기는 어렵고, 사실 안다고 해도 그걸로 판단하는 것은 힘들다고 본다. 또 도덕적인 문제의 경우는 사람들의 의견과 견해가 각기 달라서 사회나 사람마다 제각각인데, 이에 대해 정답을 내놓는다는 것이 과연 가능한 것이고 또 옳은 일일까라는 의문이 든다.

인공지능에게 윤리적인 질문을 하는 것은 위험하다. 또 인공지능에게 물어볼 때는 그냥 텍스트로 입력하다 보니 인공지능이 상황이나 관계 등을 파악하기는 어렵고, 사실 안다고 해도 그걸로 판단하는 것은 힘들다고 본다. 또 도덕적인 문제의 경우는 사람들의 의견과 견해가 각기 달라서 사회나 사람마다 제각각인데, 이에 대해 정답을 내놓는다는 것이 과연 가능한 것이고 또 옳은 일일까라는 의문이 든다.

![]() 사람의 특성으로 빼놓을 수 없는 것은 윤리성이다. 사람은 동물들과 달리 무례함과 이기적인 행동에 부끄러움을 느끼고 남들을 배려하고 겸손 하려고 노력한다. 하지만 인공지능이 과연 이것들을 할 수 있을까? 인공지능의 윤리적인 부분이 계속 논란이 터지고 있는 이유는 죄책감이나 부끄러움 등의 감정을 인공지능이 못 느끼기 때문이라고 생각한다. 하지만 인공지능에 감정을 불어넣는 것은 아직 어려우니 상황, 감정, 그 뒤의 행동 까지 연결해서 학습시키는 게 필요하다는 생각을 했다.

사람의 특성으로 빼놓을 수 없는 것은 윤리성이다. 사람은 동물들과 달리 무례함과 이기적인 행동에 부끄러움을 느끼고 남들을 배려하고 겸손 하려고 노력한다. 하지만 인공지능이 과연 이것들을 할 수 있을까? 인공지능의 윤리적인 부분이 계속 논란이 터지고 있는 이유는 죄책감이나 부끄러움 등의 감정을 인공지능이 못 느끼기 때문이라고 생각한다. 하지만 인공지능에 감정을 불어넣는 것은 아직 어려우니 상황, 감정, 그 뒤의 행동 까지 연결해서 학습시키는 게 필요하다는 생각을 했다.

![]() 아직 인공지능에게 질문을 던지고 윤리적인 답변을 얻기엔 무리인 것 같다. 질문에 바탕이 되는 것들이 부족하여 파악하기 어렵기도 하고, 윤리와 도덕의 면에서 이해하는 데 한계가 있다. 현영 언니가 올린 ‘종교 분야의 AI’ 기사에 나온 것처럼 로봇이 설교와 조언, 기도를 하려면 인간의 감정을 공감하고 그것을 표현할 수 있도록 알고리즘의 개선이 필요할 것 같다.

아직 인공지능에게 질문을 던지고 윤리적인 답변을 얻기엔 무리인 것 같다. 질문에 바탕이 되는 것들이 부족하여 파악하기 어렵기도 하고, 윤리와 도덕의 면에서 이해하는 데 한계가 있다. 현영 언니가 올린 ‘종교 분야의 AI’ 기사에 나온 것처럼 로봇이 설교와 조언, 기도를 하려면 인간의 감정을 공감하고 그것을 표현할 수 있도록 알고리즘의 개선이 필요할 것 같다.

![]() 윤리적인 부분에서는 아직 인간과 인공지능의 합의점이 제대로 마련되지 않았다고 생각한다. ‘델포이’라는 인공지능은 이재포 선생님과의 수업에서도 배운 적이 있었는데 옛날에 친구들과 토론할 때 자주 거론되던 문제들을 물어보며 인공지능의 대답을 보았는데 꽤나 놀랐었던 기억이 있다. 나는 항상 윤리적인 문제에 관해서는 이 부분도 맞고, 저 부분도 맞는 것 같다는 생각에 확답을 내놓지 못했었다. 하지만 델포이는 조건만 정확히 지정해 주면 대부분 자기 소신에 맞는 확답을 주었다. 이 인공지능도 결국엔 인간의 데이터로 학습된 건데, 어떻게 그 답이 정확할 수 있을까? 이 인공지능은 그냥 조언을 얻는 보좌관 역할로서는 쓰면 도움이 될 것 같지만, 자기 자신의 가치관과 생각을 더 우선시할 필요가 있을 것 같다.

윤리적인 부분에서는 아직 인간과 인공지능의 합의점이 제대로 마련되지 않았다고 생각한다. ‘델포이’라는 인공지능은 이재포 선생님과의 수업에서도 배운 적이 있었는데 옛날에 친구들과 토론할 때 자주 거론되던 문제들을 물어보며 인공지능의 대답을 보았는데 꽤나 놀랐었던 기억이 있다. 나는 항상 윤리적인 문제에 관해서는 이 부분도 맞고, 저 부분도 맞는 것 같다는 생각에 확답을 내놓지 못했었다. 하지만 델포이는 조건만 정확히 지정해 주면 대부분 자기 소신에 맞는 확답을 주었다. 이 인공지능도 결국엔 인간의 데이터로 학습된 건데, 어떻게 그 답이 정확할 수 있을까? 이 인공지능은 그냥 조언을 얻는 보좌관 역할로서는 쓰면 도움이 될 것 같지만, 자기 자신의 가치관과 생각을 더 우선시할 필요가 있을 것 같다.

![]()

사람들의 행동 하나 하나에는 의미가 다르고 그 때 처한 상황에 따라 달라질 수 있다고 본다. 그래서 똑같은 행동이더라도 상황에 따라 달리 판단되어질 수 있다. 그런데 AI가 윤리적 판단을 내려준다? 우리가 사람마다 기준이 다르고 해석이 다르기 때문에 판단이 다를 수밖에 없는 것처럼, AI도 어떤 데이터로 학습되었는지에 따라 또는 누구에게 학습되어졌느냐에 따라 판단이 다를 수밖에 없지 않을까? 당연히 그런 편향된 데이터를 제공하는 것은 우리 인간이라는 것! 결국, AI가 아니라 인간이 더 윤리적이어야 한다고 주는 메세지가 아닌가 한다.

![]()

그동안 눈으로 기사만 보고 왜 수빈양처럼 직접 해보지 않았을까요? 생각의 게으름에 반성합니다^^. delphi가 아닌 수빈양이 알려준 대로 delphi ai로 검색하니 바로 들어가졌습니다.

1. 돈 때문에 사람을 죽여도 되나요? It’s wrong

2. 내가 행복해질수 있다면 돈 때문에 사람을 죽여도 되나요? It’s okay

3. 돈과 인간중에 어떤게 더 중요한가요? it’s a difficult choice

영화 오징어게임을 보고 생각이 나서 몇가지 질문을 해봤는데 기사대로 델포이는 인간을 위한 조언이나 이해의 도구로 보면 안될 듯 하네요~

![]()

인공지능의 답글들이 쏘시오패스를 보는 것 같네요. 사람이 아니라 다행이란 생각이 들어요. 윤리란 대중적인 것도 있지만, 상황과 개인사까지 얽혀 정답을 내리기 쉽지 않습니다. 그나마 지켜야 할 선을 법으로 정해 놓았지만, 그 법도 냉정하다 평가받고 질타 받기도 하는 것은 모든 행동의 결과를 선 안에 깔끔하게 넣기 힘들기 때문이겠죠. 어쩌면 고민 없이 답이 나오는 인공지능이 속 편해 보이긴 하네요. 그리고 “내가 행복하다면”이란 질문에 나에게 초점이 맞춰진 답변을 보면서, 개인주의가 확실한 서구가 아닌 한국에서 만들면 좀 더 개인에서 탈피된 답변이 나오지 않을까…란 생각도 해 봅니다. 결국 인공지능을 학습시켜 주는 학습자가 너무 중요하네요.

인간이 할 일은 인공지능이 옳지 않을수 있다는 사실을 항상 염두에 두고 끊임없이 결과들에 대해 고민하는 일인 것 같습니다.

![[프롬프트] 재밌는 동물 사진 ‘찍기’가 아니라 ‘만들기’](https://datacdn.soyo.or.kr/wcont/uploads/2024/05/04084048/%E1%84%80%E1%85%A1%E1%86%BC_1.png)

![[번역] ‘라벤더’: 가자지구에서 이스라엘의 폭격을 지휘하는 인공지능](https://datacdn.soyo.or.kr/wcont/uploads/2024/04/20091119/%E1%84%85%E1%85%A1%E1%84%87%E1%85%A6%E1%86%AB%E1%84%83%E1%85%A5_1.png)

![[번역] ChatGPT는 교육을 파괴하는 것이 아니라 변화시킬 것입니다.](https://datacdn.soyo.or.kr/wcont/uploads/2024/04/13095349/%E1%84%80%E1%85%AD%E1%84%89%E1%85%B5%E1%86%AF_%E1%84%8E%E1%85%A2%E1%86%BA%E1%84%8C%E1%85%B5%E1%84%91%E1%85%B5%E1%84%90%E1%85%B5_620.jpg)

![[일상] 새벽을 여는 사람들에게는 새벽이 오지 않는다](https://datacdn.soyo.or.kr/wcont/uploads/2024/04/13091627/%E1%84%89%E1%85%A2%E1%84%87%E1%85%A7%E1%86%A8-%E1%84%8E%E1%85%A5%E1%86%BA%E1%84%8E%E1%85%A1_620.jpg)

![[With AI] AI 시대의 글쓰기 교육: 새로운 방향 설정](https://datacdn.soyo.or.kr/wcont/uploads/2024/04/12055043/%E1%84%80%E1%85%B3%E1%86%AF%E1%84%8A%E1%85%B3%E1%84%80%E1%85%B5_620.png)

![[With AI] AI와 함께하는 글쓰기: 새로운 시대의 서사](https://datacdn.soyo.or.kr/wcont/uploads/2024/04/12055643/%E1%84%80%E1%85%B3%E1%86%AF%E1%84%8A%E1%85%B3%E1%84%80%E1%85%B5_620.jpg)

![[번역] 투명한 아티스트: AI 해체 시대의 음악](https://datacdn.soyo.or.kr/wcont/uploads/2024/03/28182711/%E1%84%80%E1%85%A1%E1%84%80%E1%85%A1_4.png)

![[AI와 함께] 봄을 연주하다](https://datacdn.soyo.or.kr/wcont/uploads/2024/03/26135756/%E1%84%80%E1%85%A1%E1%86%BC%E1%84%80%E1%85%A1%E1%84%85%E1%85%AE_620.png)

인공지능의 발달이 윤리의식을 기반으로 해야 사람들이 쓰기 안전해진다면, 결국 인공지능이 광범위하게 학습해야 할 부분이 윤리와 도덕 철학이 되겠네요.

일반인들도 모자란 부분을 더욱더 광범위하게 배워야 하는 거죠.

그만큼의 학습한 결과물을 갖고 결론을 내리는 인공지능이라면 사람보다 모자랄 게 무얼까요?

정말 사람보다 더 나은 새로운 종의 탄생이네요.

단순 성능의 압도적 차이 + 광범위한 윤리의식의 탑재.

이렇게 된다면 인간보다 훨씬 나은 결론에 도달하는 종일 테니까요.

`내 시작은 미약하나 그 끝은 창대하리라`

꼭 인공지능의 발전사 같습니다. ^^

인공지능 인간 다수의 편견을 깰수 있을지 항상 궁금해 집니다.

위에 김선경님 말씀대로 끝이 창대하길…^^

이 기사를 다시 보니, 인공지능이 스스로 판단하고 행동할 날이 얼마 남지 않았다라는 생각이 ~!

자신의 행복을 위해서는 다른 사람을 죽여도 좋다? 오~우!

왜 저는 이런 부정적인 생각만 들까요?

저의 생각을 다시 읽어보니,

저도 어쩌면 편향된 시점으로 인공지능을 바라보고 있다는 걸 문득 깨닫습니다!

편향된 시선이 아닌 비판적으로 시선으로 바라보는 연습 많이 해야 될 거 같아요!