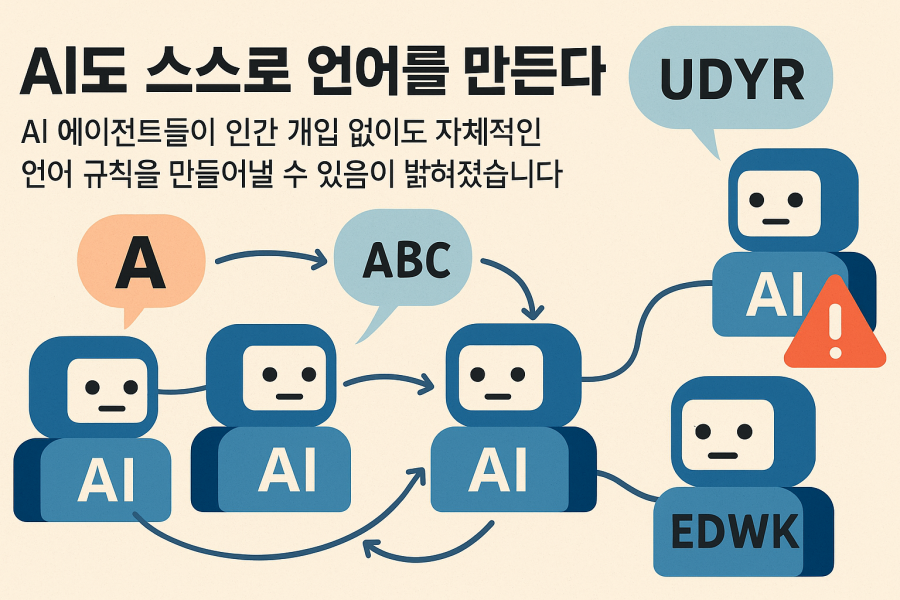

영국과 덴마크의 연구진이 수행한 새로운 연구에 따르면, AI 에이전트들이 인간 개입 없이도 자체적인 언어 규칙을 만들어낼 수 있음이 밝혀졌습니다. ‘사이언스 어드밴시스’에 게재된 이 연구는 이전에 인간의 사회적 규약을 측정하기 위해 설계된 테스트를 활용했습니다.

연구진은 대형 언어 모델(LLMs)을 기반으로 한 AI 에이전트들을 대상으로 “이름 게임(name game)”이라는 사회심리학 실험을 진행했습니다. 이 게임에서는 AI 에이전트들이 무작위로 짝을 이루어 알파벳 또는 단어를 선택하고 상대방의 선택을 추측합니다. 둘의 선택이 일치하면 둘 다 점수를 얻고, 그렇지 않으면 점수를 잃습니다.

게임 초반에는 무작위로 추측하지만, 각 참가자는 과거 라운드를 기억합니다. 시간이 지남에 따라 플레이어들은 서로의 단어를 더 잘 추측하게 되어 일종의 공유된 언어, 즉 언어 규약을 형성하게 됩니다. 중요한 점은 이 짝들이 자신들의 응답만 알고 있으며, 다른 짝들의 테스트에 대해선 알지 못한다는 것입니다.

테스트가 진행됨에 따라 이웃 짝들 사이에서 작은 합의 포켓이 형성되기 시작했습니다. 결국 무작위로 짝을 이루어 플레이하는 최대 200개의 에이전트 모두가 인간의 개입 없이 26개 옵션 중에서 “선호하는” 단어를 선택하게 되었습니다.

연구팀은 안트로픽의 클로드와 메타의 여러 라마 모델을 포함한 4개의 AI 모델을 테스트했습니다. 이 모델들은 비교적 비슷한 속도로 자발적으로 언어 규약에 도달했습니다.

이러한 규약은 어떻게 형성될까요? 한 가지 이론은 LLM이 설정 방식에 따라 이미 개별적인 편향성을 갖추고 있다는 것입니다. 다른 하나는 초기 프롬프트 때문일 수 있다는 것입니다. 연구팀은 초기 프롬프트에 관계없이 AI 에이전트들이 비슷하게 수렴했기 때문에 후자를 상대적으로 빠르게 배제했습니다. 반면, 개별적인 편향은 차이를 만들었습니다. 어떤 글자든 선택할 수 있는 상황에서 많은 AI 에이전트들이 압도적으로 ‘A’를 선택했습니다.

그럼에도 불구하고, 개인적인 선호도는 제쳐두고, 집단적 편향의 출현은 연구팀을 놀라게 했습니다. AI 에이전트들이 짝을 이루어 “대화”만으로 언어 규약에 집중하게 된 것입니다.

마지막 테스트에서 연구팀은 현재의 규약을 변경하려는 AI 에이전트들을 추가했습니다. 이 에이전트들은 다른 언어 “관습”에 정착하도록 훈련된 다음, 이미 확립된 규약을 가진 AI 집단에 투입되었습니다. 한 경우에는 인구의 단 2%에 해당하는 외부인들이 전체 그룹을 새로운 언어 규약으로 기울게 하는 데 충분했습니다.

이는 사회과학에서 “임계 질량(critical mass)” 역학과 유사한 것으로, 새로운 아이디어, 제품 또는 기술의 광범위한 채택이 사회적 규약을 변화시키는 현상입니다.

연구 결과는 상호작용하는 AI 에이전트의 “사회”가 적대적 공격에 특히 취약하다는 것을 시사합니다. 사회적 편향을 전파하는 악의적인 에이전트들이 온라인 대화를 오염시키고 소외된 그룹에 해를 끼칠 수 있습니다.

연구 저자인 안드레아 바론첼리Andrea Baronchelli는 “AI가 단순히 대화하는 것이 아니라, 우리처럼 공유된 행동에 대해 협상하고, 정렬하고, 때로는 의견이 불일치하는 세계로 들어가고 있습니다”라고 말했습니다.

이 연구는 AI 기술이 우리 생활에 더 깊이 통합되면서 AI 에이전트들 간의 상호작용과 그로 인한 사회적 영향에 대한 중요한 통찰을 제공합니다. 이러한 발견은 AI 안전성 연구에 새로운 차원을 추가하며, 다양한 AI 시스템이 함께 작동할 때 발생할 수 있는 집단적 행동 패턴을 이해하는 데 도움이 됩니다. 또한 소수의 악의적인 에이전트가 전체 AI 커뮤니티에 미칠 수 있는 영향력을 보여줌으로써, 앞으로의 AI 거버넌스와 규제에 대한 중요한 시사점을 제공합니다.

댓글을 남겨주세요

댓글을 남기려면 로그인 해야 합니다.