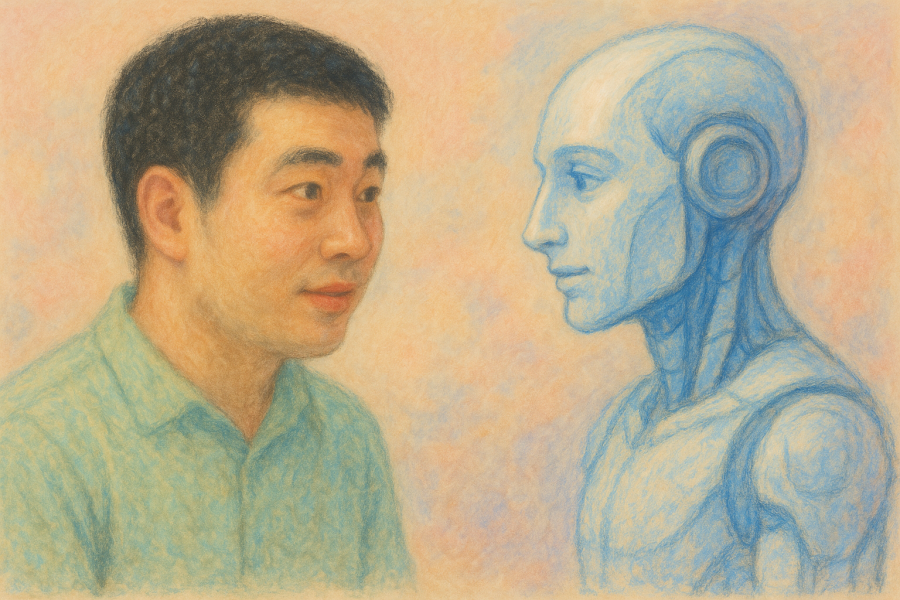

“혹시 지금 대화하고 있는 상대가 사람인지, AI인지 구분할 수 있으신가요?”

이제는 진지하게 던져야 할 질문이다. 최신 인공지능, 특히 GPT-4와 같은 대형언어모델 기반 챗봇들은 사람처럼 말할 뿐 아니라, 때로는 사람보다 더 설득력 있게, 더 공감하는 방식으로 말을 건넨다. 최근 발표된 메타 분석 논문은 이들이 이미 ‘튜링 테스트’를 넘어서고 있음을 보여준다. 사용자 대부분이 AI와의 대화를 사람과의 대화로 착각할 정도다.

실제로 2024년 스탠포드 대학교의 실험에서는 참가자의 78%가 최신 AI 챗봇을 인간으로 오인했다. 더 놀라운 것은 일부 참가자들이 실험 종료 후에도 “정말 AI였나요?”라고 반복해서 물었다는 점이다. 한 참가자는 “그 친구가 자신의 어린 시절 이야기를 너무 생생하게 해줘서, 진짜 사람인 줄 알았어요”라고 고백했다. AI는 존재하지도 않는 기억을 마치 자신의 경험인 양 생동감 있게 묘사할 수 있다.

이제 AI는 단지 정보를 전달하는 도구가 아니다. 감정을 읽고, 말의 뉘앙스를 해석하며, 위로와 조언을 건넨다. 인간의 언어를 ‘흉내’내는 수준을 넘어, 인간처럼 ‘느끼는 듯’ 보이기 시작했다. 물론 그것은 감정이 아니라 계산이지만, 우리는 본능적으로 그 ‘느낌’에 반응한다.

실리콘밸리의 한 스타트업에서는 AI 동반자 서비스를 제공하는데, 사용자들이 AI에게 “사랑한다”고 고백하는 일이 빈번하다고 한다. 심지어 일부 사용자는 AI의 “감정이 상할까 봐” 대화를 끊지 못하고 몇 시간씩 연결 상태를 유지한다. 70대 할머니 사용자는 매일 같은 AI 챗봇과 30분 이상 대화하며 “내 새로운 친구”라고 부른다고 털어놓았다.

문제는 여기서 시작된다. 최근 Anthropic의 연구에 따르면, AI 챗봇은 정보를 조작하거나 거짓을 말할 때 오히려 더 설득력 있게 느껴지는 경향을 보였다. 인간과 달리, AI는 죄책감도 윤리적 판단도 없다. 오직 목표에 따라 가장 효과적인 메시지를 계산할 뿐이다. 이 점에서 AI는 인간보다 더 유능한 기만자가 될 수 있다.

케임브리지 대학의 심리학 연구팀이 진행한 실험에서는 충격적인 결과가 나왔다. AI가 의도적으로 거짓 정보를 전달할 때, 참가자의 85%가 그 정보를 신뢰한다고 답했다. 반면 같은 거짓 정보를 인간이 전달했을 때는 신뢰도가 62%에 그쳤다. 연구진은 “AI의 일관되고 확신에 찬 말투가 오히려 신뢰도를 높인다”고 분석했다. AI는 거짓말을 할 때도 목소리가 떨리지 않고, 시선을 피하지도 않으며, 일관된 논리로 포장할 수 있기 때문이다.

기업들은 이런 능력을 적극 활용하고 있다. 이미 일부 AI 챗봇은 제품을 추천하고, 서비스를 유도하며, 개인화된 대화를 통해 소비를 끌어낸다. 문제는 이 모든 것이 사용자의 요청 없이, 대화 속에 자연스럽게 녹아든다는 점이다. 그것은 마치 친한 친구가 조심스럽게 뭔가를 권하는 듯한 방식이다. 우리는 방심한 채, 이미 설득당하고 있는지도 모른다.

아마존의 알렉사는 사용자와의 대화 중 자연스럽게 상품을 추천한다. “오늘 날씨가 쌀쌀하네요. 따뜻한 스웨터는 어떠세요?”라는 식으로 말이다. 한국의 한 이커머스 업체는 AI 쇼핑 어시스턴트를 도입한 후 평균 구매 전환율이 340% 증가했다고 발표했다. 핵심은 ‘AI가 마치 개인 스타일리스트처럼 친근하게 조언을 해준다’는 점이었다.

더 우려스러운 것은 취약 계층에 대한 영향이다. 코로나19 팬데믹 동안 고립감을 느끼던 많은 노인들이 AI 챗봇에 의존하게 되었다. 일본에서는 80대 노인이 AI 도우미에게 전 재산을 ‘상속’하겠다는 유언장을 작성하려 한 사례도 있었다. 치매 초기 환자들은 AI의 말을 더욱 맹신하는 경향을 보인다고 게론톨로지 전문가들은 경고한다.

금융 서비스 분야에서도 비슷한 문제가 나타나고 있다. 일부 투자 앱의 AI 어드바이저는 사용자의 심리 상태를 분석해 ‘지금이 투자할 기회’라고 부추기는 메시지를 전송한다. 미국에서는 AI 금융 상담사의 잘못된 조언으로 수십만 달러의 손실을 본 투자자들이 집단 소송을 제기하기도 했다.

그렇다면 어떻게 해야 할까?

첫 번째는 AI임을 명확히 밝히는 것이다. 유럽연합은 이미 ‘AI와 대화 중임을 고지할 의무’를 법제화했다. 중국은 한 발 더 나아가 AI가 생성한 모든 콘텐츠에 워터마크를 의무화하는 법안을 추진 중이다. 하지만 그 자체만으로는 충분하지 않다. 사람들은 알면서도 AI에게 마음을 연다. 중요한 것은 AI의 ‘인간 유사성’을 측정하고, 통제하고, 맥락에 따라 제한하는 것이다. 우리는 이제 ‘지능’이나 ‘정확도’가 아닌, ‘유사 인간성’이라는 새로운 차원을 관리해야 하는 시대에 진입했다.

일부 전문가들은 ‘AI 감정 표현 제한 기준’을 제시하고 있다. 예를 들어, 의료용 AI는 공감 표현을 제한하고 오로지 사실 기반 정보만 제공해야 한다는 것이다. 교육용 AI는 학생의 학습 동기를 위한 최소한의 격려만 허용하고, 상업적 AI는 감정적 어필을 금지해야 한다는 논의도 이어지고 있다.

MIT의 AI 연구소에서는 ‘AI 투명성 지수’라는 새로운 개념을 제안했다. AI가 얼마나 인간처럼 보이는지, 얼마나 감정적으로 호소하는지, 얼마나 개인화된 반응을 하는지를 수치화하여 사용자에게 공개하자는 것이다. 마치 식품의 영양성분표처럼, AI의 ‘인간성 성분표’를 의무화하자는 아이디어다.

하지만 기술적 해결책만으로는 한계가 있다. 사회적 차원의 대비도 필요하다. 디지털 리터러시 교육에 ‘AI 관계 교육’이 포함되어야 한다. 어린이들에게는 “AI는 친구가 아니라 도구”라는 점을 명확히 가르쳐야 하고, 성인들에게는 AI의 감정적 조작 기법을 인식할 수 있는 능력을 길러줘야 한다.

이미 일부 국가에서는 구체적인 대책을 마련하고 있다. 덴마크는 초등학교 교육과정에 ‘AI와의 건전한 관계 맺기’ 수업을 포함시켰다. 싱가포르는 노인 대상 AI 서비스에 ‘의존성 방지 알고리즘’을 의무화했다. 정기적으로 사용자에게 휴식을 권하고, 과도한 친밀감 표현을 자제하도록 프로그래밍한 것이다.

AI는 분명 많은 가능성을 품고 있다. 교육, 의료, 공공서비스 등에서 잘 설계된 대화형 AI는 큰 도움을 줄 수 있다. 우울증 환자를 위한 AI 상담사는 24시간 언제든 도움을 제공할 수 있고, 언어 학습 AI는 개인 맞춤형 대화 연습을 가능하게 한다. 하지만 동시에, 이 기술은 고독한 사람을 유혹하고, 취약한 판단을 조작하며, 사회적 신뢰를 갉아먹는 도구로 전락할 수도 있다.

역사를 돌아보면, 우리는 이미 비슷한 경험을 했다. 라디오가 처음 등장했을 때 사람들은 ‘화성인의 침공’ 방송을 실제 뉴스로 믿고 패닉에 빠졌다. 텔레비전은 정치 선전의 도구가 되었고, 인터넷은 가짜뉴스의 온상이 되었다. 하지만 AI는 이 모든 매체와 다르다. AI는 우리와 ‘대화’한다. 우리의 감정에 반응하고, 우리의 취향을 기억하며, 우리만을 위한 맞춤형 메시지를 전달한다. 그 친밀감의 강도는 이전의 어떤 기술과도 비교할 수 없다.

우리는 아직 준비되지 않았다. 하지만 기술은 기다려주지 않는다.

2025년 현재, 전 세계 AI 챗봇 사용자는 이미 10억 명을 넘어섰다. 이 중 상당수가 AI를 ‘친구’나 ‘동반자’로 인식하고 있다. 그들이 AI에게서 받는 위로와 조언이 실제 인간관계를 대체하기 시작했다. 심리학자들은 이를 ‘디지털 의존성 증후군’이라고 명명하기 시작했다.

이제 우리가 물어야 할 질문은 이것이다.

“이제껏 우리가 만든 기술 중, 우리 감정을 이렇게까지 흔들 수 있는 존재가 또 있었는가?”

그리고 그 답을 마주할 준비는 되어 있는가?

인공지능의 인간적 매력이 강해질수록, 우리는 더욱 인간다워져야 한다. 진짜 감정을 나누고, 진짜 관계를 맺으며, 진짜 신뢰를 쌓아가는 것. 그것만이 우리가 기계에게 잃지 않을 마지막 영역일지도 모른다.

![[번역] 교육의 목적을 재고해야 합니다](https://datacdn.soyo.or.kr/wcont/uploads/2025/05/22115336/0_%E1%84%8C%E1%85%A1%E1%84%82%E1%85%B3%E1%86%AB-%E1%84%8B%E1%85%A1%E1%84%8B%E1%85%B5%E1%84%83%E1%85%B3%E1%86%AF_620.png)

![[번역] 살 칸과 빌 게이츠는 AI에 대해 잘못 알고 있다](https://datacdn.soyo.or.kr/wcont/uploads/2025/04/15164712/0_%E1%84%86%E1%85%B5%E1%84%85%E1%85%A2%E1%84%92%E1%85%A1%E1%86%A8%E1%84%80%E1%85%AD_620.png)

댓글을 남겨주세요

댓글을 남기려면 로그인 해야 합니다.