오랜만에 글을 씁니다. 오늘 찾아본 소식은 약 1달이 지난 오래된(?) 소식이지만 이전 3월에 작성했던 글과 연계되는 것이라 흥미로웠습니다. 당시 쯔위엔연구원(BAAI, Beijing Academy of Artificial Intelligence)이 개발한 대규모 AI 모델 “우따오1.0″을 소개했었습니다. 약 3개월이 지난 지금 우따오2.0이 발표되었고, 파라미터 수는 증가하고 응용(application) 양상은 명확해졌습니다.

개인적으로 대학 졸업과 취업 준비를 한 3개월 동안 다른 한편에선 AI 연구가 더욱 활발해지고 그 속도 역시 너무나 빠르다는 점에서 충격적이면서도 인상 깊었던 내용이었습니다.

쯔위엔(智源), 세계 최대 사전학습 모델 “우따오(悟道)2.0” 발표, 쯔푸(智谱)AI 등 여러 기관과 공동 개발

지난 3월 22일, 중국의 대규모 AI 모델인 우따오1.0이 소개되었습니다. 바이두, 샤오미, 바이트댄스, 매그비 등 다양한 IT 기업과 연구기관들이 모여 연구를 진행하는 곳인 쯔위엔연구원에서 개발한 모델이었죠. 그로부터 3개월 지나지 않은 6월 3일, 2021 베이징 쯔위엔 컨퍼런스(北京智源大会)가 개최되었고, 우따오2.0 모델이 등장했습니다.

우따오2.0 특징: 최대, 표준, 통용, 국산

쯔위엔 연구를 이끄는 칭화대학교 교수 탕제(唐杰)는 우따오 모델의 목적이 세계 최고의 수준의 AGI(Artificial General Intelligence) 개발이라고 했습니다. AI가 정말 사람처럼 생각하고 행동하도록 만들겠다는 뜻입니다.

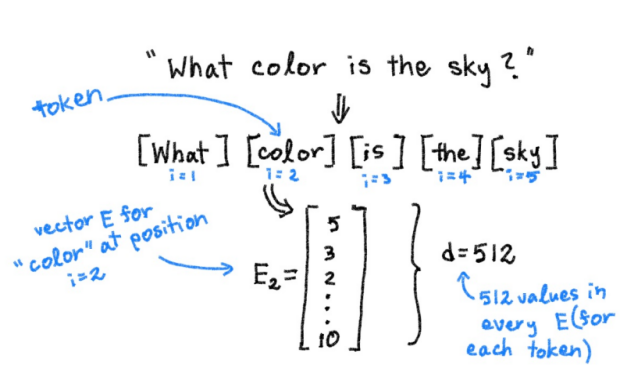

먼저, 우따오는 4.9TB의 고품질 텍스트, 이미지 데이터를 학습했다고 합니다. GPT-3의 학습 데이터셋이 570GB라는 점에서 규모를 가늠해볼 수 있습니다. 물론 GPT-3 역시 원본 데이터셋은 45TB로, 연구원들이 이 중에서 570GB의 고품질 데이터를 추출했습니다.

또한 우따오의 파라미터 수는 1조 7500억 개에 달하며, 이는 파라미터가 1조 6000억 개인 구글의 Switch Transformer 사전학습 모델을 뛰어넘은 것입니다. 동시에 OpenAI가 개발한 GTP-3의 파라미터(1750억 개)의 10배에 달하는 것입니다. 또 하나 눈여겨볼 점은 우따오 모델은 중국이 독자적으로 연구 생산한 GPU 플랫폼을 기반으로 했다는 것입니다.

쯔위엔 연구원들이 대규모 사전학습 모델을 개발하는 이유는 무엇일까요? 바로 구글의 MoE(Mixture-of-Expert training system) 기술의 한계인 병목현상을 해결하고, 조(兆) 단위의 모델을 실현하기 위해서입니다. MoE의 아이디어는 큰 모델 안에서 목적에 맞춰 서로 다른 모델을 훈련하는 것입니다. 쯔위엔이 개발한 FastMoE(https://arxiv.org/abs/2103.13262)는 파이토치(PyTorch) 프레임까지 지원하는 최초의 MoE 시스템으로 가용성, 유연성, 훈련속도 측면에서 강점을 보입니다. 구글의 MoE와 다르게 오픈소스 형태이고, 특정 하드웨어를 필요로 하지 않습니다.

이미 ImageNet, LAMA, LAMBADA, SuperGLUE, MSCOCO 등 여러 벤치마크 테스트에서 좋은 성적을 냈고, 9개 항목에서 SOTA 성능을 기록했습니다. 탕제에 의하면 우따오2.0 사전학습 프레임워크는 5가지 고효율 특징이 있습니다.

1. 고효율 코딩

2. 고효율 모델

3. 고효율 학습

4. 고효율 파인튜닝

5. 고효율 추리

이를 바탕으로 한 우따오2.0은 중국어 텍스트 데이터, 멀티모달 데이터, 대화음성 데이터까지 모두를 통합한 거대 데이터 모음집이라 할 수 있습니다.

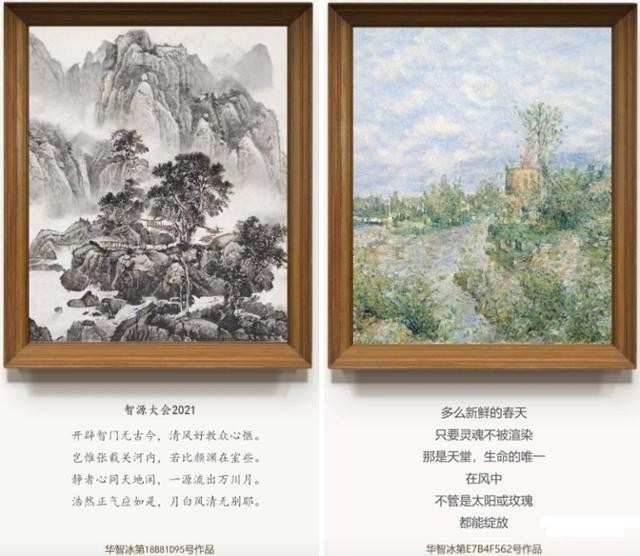

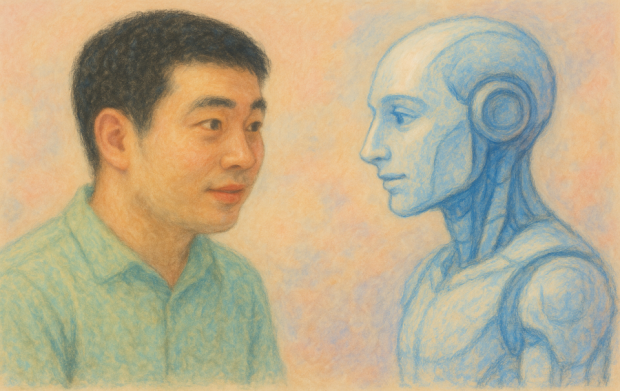

쯔푸AI, 샤오빙(小冰)과 합작 개발한 화쯔빙(华智冰)

화쯔빙은 가상 학생으로 칭화대 컴퓨터학과 지식공학실험실(知识工程实验室)에 입학했고, 학생증과 학교 이메일 계정도 발급을 받으며 정식으로 인정받았습니다. 쯔푸AI 데이터베이스를 바탕으로 샤오빙의 인지, 추리 기술력을 합친 최초의 완전한 가상 디지털 인간입니다.

[그림1]쯔화빙 사진

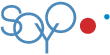

아래는 화쯔빙이 그린 그림과 작성한 시 문구입니다.

[그림2]화쯔빙의 그림과 시

무척이나 신선한 봄이구나

영혼만 물들지 않는다면

그것이 극락이요, 활기찬 생명의 현장이다

거센 바람이 분다 하더라도

태양과 장미 모두

활짝 필 것이다

화쯔빙은 칭화대학교를 다니면서 지도 교수인 탕제의 가이드에 따라 더욱 업그레이드될 예정입니다. 하나의 작업으로 웹 페이지 섹션이나 프로젝트 아키텍트를 자동으로 설계하고, 내부 코드를 업데이트하여 정상적으로 실행할 수 있을 정도로 말입니다. 이는 화쯔빙이 할 수 있는 일부일 뿐, 앞으로의 활용 분야는 무궁무진할 것으로 예상되고 있습니다.

아래 쯔화빙의 자기소개 영상을 살펴봐도 좋을 듯 합니다.

구글의 MoE 기술의 병목현상 해결, 조 단위 모델 실현, 파이토치 프레임까지 지원, 오픈소스 형태, 특정 하드웨어를 필요로 하지 않는다…

디지털 세계의 패권 선점을 위한 패로 보여요.

쉽게 쓸 수 있는 편리한 오픈소스가 여기 있으니 딴 거 쓰지 말고 이리 모여~ 하고 유혹하는 거요.

지금 구글의 위치가 막강한 이유 중 하나가 오픈소스와 그 오픈소스와 연계된 앱들의 모임으로 이루어진 거대한 플랫폼의 형성이라고 생각하거든요.

구글과 연계되면 편리하잖아요.

더 편리하니 오라하네요. 데이터 세트는 신용할 만 한지도 모르겠구요. 중국이 잘 하면 저는 왜 불안할까요ㅠㅠ

파라미터가 1조 7500억개나 된다는 글을 보자마자, 대단하다는 생각보다 비트코인 채굴공장으로 인해 수온이 너무 올라간 뉴욕의 어느 호수에 대한 기사부터 떠오르네요.ㅠㅠ

그리고 완전한 디지털 가상 인간이라…

개인적인 생각인데, 인구 수는 가상이던 실제이던 안 불었으면 좋겠네요.

둘 다 지구의 에너지를 쓰는 측면에서 뭐…

기술의 발전이 가져오는 편리함이 과연 인간을 위하는 길인지도 모르겠습니다.

세상사 잘 몰라서 갖게 되는 편견이지만…

성장은 빠르고 강력한 파괴의 발판 위에 마련되고, 회복과 재건은 달팽이마냥 뒤쳐져 있는 것 같네요.

그냥 강대국이 디지털 세상에서도 강대국이 되는 현실도 슬프네요. 현실이나 가상이나…

우따오 2.0 구글의 MoE를 능가하는 기술이라는 것이지요?

중국과 미국의 기술패권다툼을 보며 저희의 마음이 무거워지는건 왜일까요?

중국에서 구글의 moe보다 앞선 사전 학습모델이 나왔다니 무섭군요ㄷㄷ